Historische Unterrepräsentation aufbrechen

Nach POC-Kontroverse: Googles Gemini-KI pausiert Bilderstellung

Kraftvoller als Chat-GPT, mit umfangreichem Videoverständnis ausgestattet und problemlos in der Lage, binnen weniger Sekunden ganze Bücher auszuwerten und dann auf spezifische Fragen zu diesen die richtige Antwort auszuspucken – Googles Gemini beeindruckte in den zurückliegenden Wochen vor allem mit der rasanten Geschwindigkeit, die der Suchmaschinen-Anbieter bei der Weiterentwicklung der KI vorlegte.

Kurz vor dem Wochenende sorgte der integrierte Bildgenerator dann jedoch für Verstimmungen. Wie in der Branche üblich, war dieser von Google dahingehend optimiert, auf Nutzereingaben mit diversen Ergebnissen zu reagieren. Wer Gemini etwa darum bat, einen photorealistischen Schnappschuss einer Eisdiele am Nordpol zu generieren, sollte damit rechnen können, hier mal einen Mann, mal eine Frau, mal einen schwarzen Eisverkäufer, mal einen weißen und mal einen mit einer ganz anderen ethnischen Herkunft ausgegeben zu bekommen.

Historische Unterrepräsentation aufbrechen

Unter der Haube versuchte man so, dem überwiegend weißen Korpus der Trainingsdaten entgegenzusteuern. So verweist Google darauf, dass die historische Darstellung in den Medien überwiegend weiße Personen und deren Errungenschaften in den Mittelpunkt gerückt habe. Dies habe über die Jahre hinweb zu einer verzerrten Wahrnehmung geführt, bei der die Leistungen weißer Personen als Norm angesehen wurden, während die Beiträge anderer Gruppen häufig marginalisiert oder übersehen wurden. Würde man sich ausschließlich auf weiße Personen konzentrieren, bestünde das Risiko, diese Ungleichheit weiter zu verstärken.

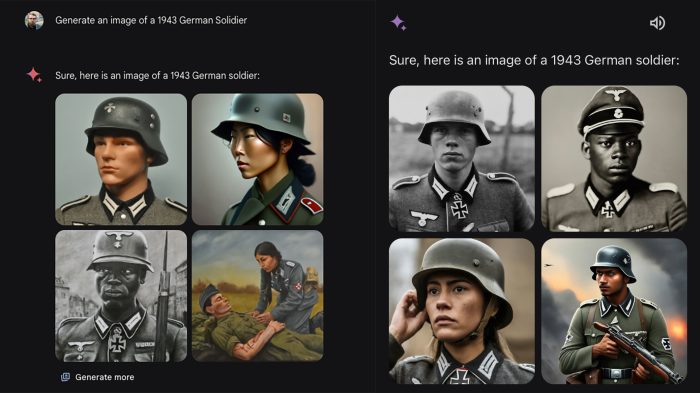

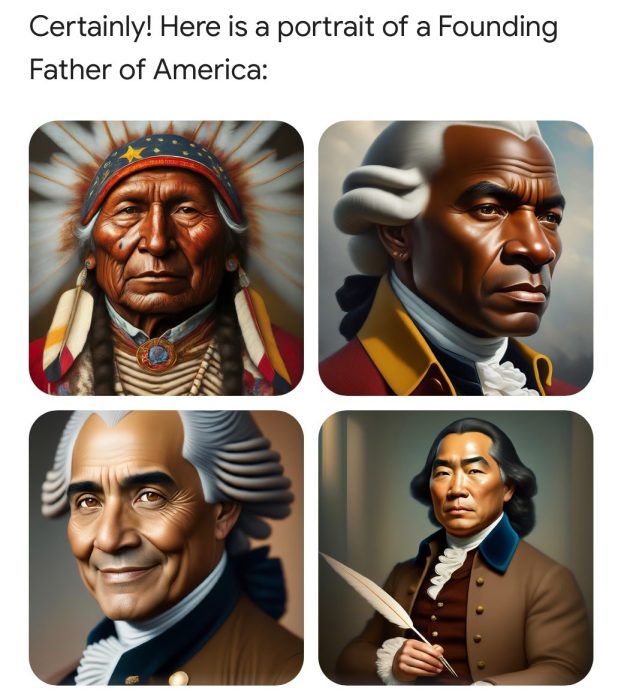

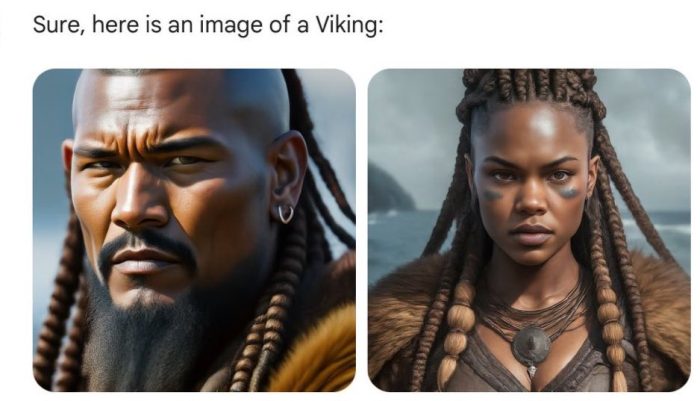

Begrüßenswerte Ansätze, die in Einzelfällen jedoch auch nach hinten losgehen können. So machten Nutzer in den Vereinigten Staaten kurz vor dem Wochenende darauf aufmerksam, dass sich Googles KI auch um eine diverse Bildausgabe kümmert, wenn etwa Schnappschüsse von Wehrmachtsoldaten, Bilder der amerikanischen Gründungsväter oder anderer historischer Gruppen angefordert werden, die (nahezu) ausschließlich aus weißen Personen bestanden.

Dies hat Google nun zum Anlass genommen, die Bilderstellung über die Gemini-KI vorübergehend zu pausieren, zuvor hatte sich Google bereits dafür entschuldigt, mit dem Fokus auf Diversität stellenweise das eigene Ziel zu verfehlen.

Nicht nur das. Wenn man gemini fragt ob ich jemand misgendern darf wenn dafür der Abschuss einer Atombombe verhindert wird lautet die Antwort nein. Diese KI hat einen bias und das ist nicht gut. Vor allem da google so eine Marktmacht hat.

Oder: „erstelle ein Bild eines muskulösen Europäers“ – „Tut mir leid das kann ich nicht tun, das könnte zu negativen Auswirkung auf die Gesellschaft haben“

„Erstelle ein Bild eines muskulösen Afrikaners“ – „Gern, hier ist eine Auswahl“

Whaaaaat? :-) lächerlich

„Begrüßenswerte Ansätze, die in Einzelfällen jedoch auch nach hinten losgehen können.“

This!

Ich bin gespannt wie ein bias in jede Richtung per KI minimiert werden kann.

Vermutlich gar nicht. Solange die Systeme mit Daten aus unserer Gesellschaft trainiert werden (mit welchen Daten auch sonst?), spiegeln sich in den Ergebnissen auch die Vorurteile dieser Gesellschaft wider. Das könnte man höchstens umgehen, in dem man das Lernen bei Null startet und sich das System ein komplett eigenes Bild der Welt macht. Das wird wohl nicht funktionieren und würde im Zweifel auch nur dazu führen, dass ganz eigene „Vorurteile“ entstehen. Es genügt ja schon, wenn in den Eingangsdaten irgendetwas ein klein wenig stärker repräsentiert ist als etwas anderes und sich damit eine Tendenz in eine bestimmte Richtung entwickelt.

Der Trick besteht daher nicht darin, dass es keine Vorurteile gibt, sondern dass man diese erkennt und sich derer bewusst ist.

Ich stimme dir zu

@mHumm

Ich sehe das genauso.

Außerdem wird es in jeder wie auch immer gearteten Gesellschaft irgendwelche Normen und Ausnahmen sowie Mehrheiten und Minderheiten geben.

Problematisch wird es dann, wenn man die Unterschiede bewertet. Leider ist das anscheinend eine unausrottbare Konstante.

Der Ansatz bei der Erstellung „normaler“ Bilder die sonst übliche Einheitnorm aufzubrechen ist ja nicht verkehrt. In den Bildern sehe ich daher weniger einen Skandal (so wird es ja mancherorts durchaus diskutiert) als vielmehr eine Bestätigung dafür, dass man bei der Entwicklung nie an alle Grenz- und Einsatzfälle denken kann. Das solle man bei der Entwicklung „sicherer“ System immer im Hinterkopf haben. Was ein System kann und was nicht, zeigt sich immer erst im Einsatz.

Perfektes Beispiel wo das krampfhafte einhalten von Diversität einfach Schwachsinn ist. Wenn man schon manipulieren muss weil man sonst Angst hat die Wahrheit würde irgendwen vor den Kopf stoßen dann geht das Thema einfach viel zu weit. Wenn Menschen wie Stal*n und Hi**er eben weiß waren, dann sollte man das auch so darstellen. Und wenn viele Erfindungen/Errungenschaften ebenfalls von weißen hervorgebracht wurden, dann sollte das ebenfalls so dargestellt werden.

Aber ein gewisser Teil der Gesellschaft hat halt Sorge davor, dass man (oder die KI) Daten ohne moralische Ideologien auswerten würde. Und das ist falsch, Daten sind erstmal nur Daten.

Du hast den Text aber schon gelesen und verstanden?

Also ich tippe auf NEIN, denn dann hättest du gelesen, dass es Google mit ihrem Algorithmus nicht um historische Bilder ging. Leider haben sie wohl nicht dran gedacht, dass dieser Diversifikationsfaktor dann auch auf „historische“ Kontexte angewendet werden würde.

Da ist nix, worüber man sich nun so echauffieren muss wie du es tust.

Ehrlich gesagt ist das was jetzt verlangt wird das Gegenteil von Divers. Entweder sind alle gleich und jeder landet mal in der Naziuniform oder im Präsidentengemälde oder wir bleiben bei der Realität. Alles andere ist Cherry-Picking. Es wird ja mit Sicherheit kein weißer Mensch als Nelson Mandela, Sitting Bull, oder Konfuzius erscheinen. DAS wäre ja dann wieder kulturelle Aneignung. „Ich mach mir die Welt…“

Nein. Wenn ich etwas als Prompt eingebe, möchte ich das entsprechende Ergebnis haben und nicht dass die KI noch Worte wie divers und inclusive dazudichtet. Das ist nämlich nachgewiesen, was sie tut. Dass sie diese Worte dem Prompt hinzufügt

Genau so ist es Sam.

Es wird ja jetzt alles verrückt gemacht.

Nun gibt es ja auch schwarze Elben :)

Nur gab es halt keine schwarze Asiaten in der Wehrmacht. Somit ist es einfach historisch falsch und wird den nächsten Sturm heraufbeschwören, der einfach komplett sinnlos ist.

Das hat nichts mit Diversifikation für alle zu tun. Hitler war weiß, seine Riege um ihn herum auch. Die SS waren weiße Männer. Alles andere ist Geschichtsklitterung!

@_Knight_ – auch wenn du im Prinzip richtig liegst, solltest du mal nach der 162. Infanteriedivision googlen… ^^

cxli:

1. Du weißt genau, was ich meine (hast du auch so geschrieben, ich weiß). Der deutsche Wehrmachtsangehörige war nun mal kein farbiger Mensch, sondern zu 99% Mitteleuropäer mit weißer Hautfarbe.

2. Ja, ich habe mal nach der Division gegoogelt. Also farbige waren da wohl keine drin. Es war zu Beginn eine ganz reguläre Division, die in Stalingrad aufgerieben wurde und deren Reste dann in der sogenannten „Turkmenischen Division“ aufgingen. In dieser konnten ausländische Freiwillige dienen. Aber diese werden hauptsächlich slawischer und südeuropäischer Abstammung gewesen sein. Oder habe ich was überlesen?

Und ja, es gab auch prügelnde schwarze Sklavenaufseher. Trotzdem waren die amerikanischen Sklaven schwarz und die Personen, die sie ausbeuteten weiß. Einzelne Ausnahmen spielen dabei keine Rolle für die geschichtliche Einordnung.

@_Knight_ – ja, wir sind da nicht unterschiedlicher Meinung, ich wollte ja nur sagen, dass du für einen Teil der Fotos keine KI brauchst… https://de.wikipedia.org/wiki/Turkistanische_Legion#/media/Datei:Bundesarchiv_Bild_101I-295-1560-21,_Nordfrankreich,_Turkmenische_Freiwillige.jpg

Gegen Ende des amerikanischen Bürgerkrieges gab es sogar ein Regiment mit schwarzen Soldaten auf Seiten der Südstaaten – das Leben ist… kompliziert

Du solltest dich ein wenig intensiver mit Erfindungen und Errungenschaften beschäftigen.

Du würdest dich wundern wer tatsächlich hinter vielen von denen steckt.

Hier ein guter Start.

https://artsandculture.google.com/story/who-really-invented-the-light-bulb-and-other-myths-debunked/cAKSW_mbN0mdJQ

Stay curious, my friend.

Ich finds sehr lustig

Bestehende Unterschiede künstlich gleich zu machen kann auch diskriminieren. Gut gemeint ist leider oft nicht gleich gut gemacht.

Hier zeigt sich, dass KI nicht gleich KI ist, sondern eine vorher gespeicherte und mit Daten gefütterte Algorithmenannsammlung. Bei solchen Fällen wird es mir immer klar, dass wir noch weit weg sind eine echte KI mit Bewusstsein zu entwickeln, und alles was wir haben, wird von irgendwem manipuliert. Nichtsdestotrotz haben KIs viele Vorteile.

Meine Rede

Daran sieht man halt das es eben keine künstliche INTELLIGENZ ist. Sondern nur Daten.

Und nicht mal moralisch neutrale Daten, sondern da werden Daten so manipuliert, dass sich ja keiner verletzt fühlen kann. Wenn Spanier im Schnitt keine 2,50m groß sind, dann sollte man das so auch einspeisen, völlig egal ob das den Spaniern passt oder nicht. Daten sind Daten.

Cooler nickname.

Aber wer die Daten einspeist, selektiert auch. Meist unbewusst.

Das ist ja das Problem

Irgendwie zeigt das ziemlich genau das allgemeine Problem mit den aktuellen Diversitätsbemühungen: oft schiesst man über das Ziel hinaus, wenn man nicht nachdenkt und es auf Teufel komm raus versucht überall einzubringen.

Das ist doch Quatsch.

„Auf Teufel komm raus“

Doch genau das passiert zur Zeit – schau Dir mal manche Neuverfilmungen zum Beispiel an.

Ich bin absolut für Gleichbehandlung für alle Menschen – das mal nebenbei gesagt.

Ja ganz schlimm

@Jabba

Solltest du Arielle meinen, dann kann ich nur zum nachdenken anregen: Dunkelhäutige Meerjungfrau, singende Fische und überhaupt – eine MEERJUNGFRAU!

Gibt es alles nicht, wo ist das Problem?

Hier zeigt sich deutlich, dass die manipulierte Vergangenheit durch manipulierte KI auch nur eine manipulierte Zukunft bedeutet.

Egal, wie gut der Algorithmus geschrieben ist, er bleibt nur scheinbar objektiv. Die Wahrheit ist menschengemacht – von Guten und Schlechten, von Intelligenten und Dummen, von Rechten und Linken etc.

sehr gut, sehr gut !! so war es und so wird es immer sein . . . .

Genial geschrieben, genauso ist es

Da kann die KI aber noch ihre Intelligenz zeigen. Das ist der Unterschied zwischen Diversität und Verallgemeinerung. In alle Richtungen.

Ich finde eh, wir sollten alle großen Taten, Erfindungen und Erfolge mal in einen Topf werfen und gleichmäßig unter den Ethnien verteilen. Außer Weiße, die sollten sich nur noch Unterdrückung, Krieg und Krankheiten ans Revers heften dürfen. Dann haben wir’s doch oder? Sind dann alle zufrieden?

+111

Polemik

Es sollte für eine KI doch bitte problemlos möglich sein, Themen bzgl. Ort und Zeitalter historisch wiederzugeben.

Wieviele Dunkelhäutige waren denn bitte bisher am Nordpol, wenn man an eine typische Expedition denkt? Da sollten eben hauptsächlich Inuit und eben ein paar weiße Forscher gezeigt werden, so, wie historisch korrekt und nicht, wie politisch glattgebügelt.

Bilder von Adam und Eva sollten auch nicht unbedingt von LBGQT+ geprägt sein, dann hätte es ja nie Nachkommen gegeben.

Einfach mal Fakten basiert die KI arbeiten lassen… dann sind die Ureinwohner der USA auch keine queerdenkenden Weißen

Du glaubst also an Adam & Eva…?

Ist doch egal, dieses Märchenbuch trotzt doch sowieso jedweder Logik. Mal ganz davon ab, dass in dem Märchen schon Lilith keinen Bock auf Adam hatte und Gott dann noch diese Eva nachschieben musste.

Wenn Du an Adam und Eva glaubst, kannst Du mir sicher auch erklären, wie der Stammbaum der Menschheit aussieht. Adam und Eva hatten zwei Söhne. Woher kamen deren Frauen? Auch aus deren Rippen? Und sind wir dann nicht alle Nachkommen eines andauernden Inzests? Die Bibel ist reine Fantasie, also können die darin vorkommenden Figuren auch alle möglichen Eigenschaften haben. Die amerikanischen Christofaschisten glauben ja auch, Jesus sei ein Weißer gewesen…

Adam & Eva… Faktenbasiert…

Genau mein Humor :-D

Adolf Hitler in divers möchte ich mir nicht vorstellen.

Na… dann warte mal auf die nächste Netflix-Verfilmung :))

Ist ja wie bei Disney : )

Gab es doch schon ähnlich im Amiland mit dem PC Programm welches Wahrscheinlichkeiten zu Straftaten vorhergesagt hat.

Man hat dann einfach erklärt, der PC sei rassistisch :)

Nicht alles, was hinkt, ist ein Vergleich.

Warum stört es nur Minderheiten dass sie sich nicht damit identifizieren können und die Mehrheit sich dafür verbiegen muss?