Trotz laufender iCloud-Prüfung seit 2020

Missbrauchs-Fotos: Apple hat 2020 nur 265 Bilder gemeldet

Noch immer ist das Netz auf der Suche nach Gründen, die Apple dazu veranlasst haben könnten, sich dafür zu entscheiden auf den iPhone-Modellen von Millionen Kunden die Software-Voraussetzungen zu schaffen, um lokale Fotos nach möglichen Missbrauchsbildern zu durchsuchen.

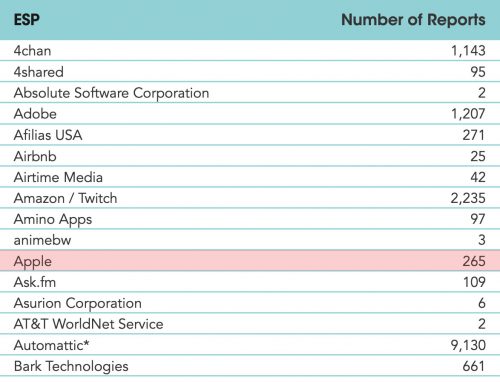

2020-Reports by Electronic Service Providers | Quelle: NCMEC

Zwar hat Apple die am vergangenen Donnerstag angekündigte Neuerung von iOS 15 mit zahlreichen Einschränkungen versehen (gescannt werden nur Fotos die in die iCloud geladen werden, gescannt wird vorerst nur in den USA, Treffer sollen von Apple gesichtet werden, weiteren Ländern wird erst nach „rechtlicher Prüfung“ Zugriff auf das System gewährt) zeigt sich vom webweiten Aufschrei ansonsten aber weitgehend unbeeindruckt.

Trotz laufender iCloud-Prüfung seit 2020

Wirft man einen Blick auf die offiziellen Statistiken, die das National Center for Missing and Exploited Children (NCMEC) jährlich veröffentlicht, werden die Fragezeichen nur noch größer. Im Report über die Anzahl der von Service-Providern gemeldeten Missbrauchs-Fotos 2020 taucht Apple lediglich mit 265 gemeldeten Verdachtsfällen auf.

Zum Vergleich: Dropbox hat mit 20,928 Bildern knapp das Hundertfache gemeldet, Facebook hat über 20 Millionen Fotos an das NCMEC übergeben.

265 Bilder, obwohl Apple alle in iCloud gesicherten Fotos bereits seit 2020 auf den iCloud-Servern nach Bildern durchsucht, auf denen die sexuelle Ausbeutung von Kindern zu sehen ist. Um diese fortan schon vor dem Upload in die iCloud zu finden, sollen nun entsprechende Software-Vorbereitungen auf über einer Milliarde aktiv genutzter iOS-Geräte getroffen werden.

Experten hinterfragen astronomische Fehlerrate

Wo wir gerade bei der Auswertung von Statistiken sind: Laut Apple soll die Falsch-Positiv-Rate bei 1 zu 1 Billion liegen. Eine Behauptung, die inzwischen von Experten hinterfragt wird. Dr. Neal Krawetz von FotoForensics etwa schreibt „I’m calling bullshit on this„.

Beispiel Facebook: Bei über 20 Millionen gemeldeten Missbrauchs-Fotos geht Krawetz davon aus, dass Nutzer im Meldezeitraum etwa 36 Milliarden Bilder auf Facebook hochgeladen haben. Entsprechend würde es 30 Jahre dauern, ehe Apple bei gleichem Bildaufkommen den ersten Falsch-Positiv-Treffer hätte.

Krawetz bezweifelt, dass Apple überhaupt eine Billion valider Testfotos besitzt. Eine sehr lesenswerte Analyse.

According to all of the reports I’ve seen, Facebook has more accessible photos than Apple. Remember: Apple says that they do not have access to users‘ photos on iCloud, so I do not believe that they have access to 1 trillion pictures for testing. So where else could they get 1 trillion pictures?

Zum Nachlesen

- Kinderporno-Scan: Apples Antworten lassen viele Fragen offen

- Kinderporno-Scan: Apple hofft auf ein Missverständnis

- Kinderporno-Scan: Apple erntet Kritik von allen Seiten

- Dickpic per iMessage: iOS 15 warnt vor Penis-Bildern

- Missbrauchsfotos: Das iPhone prüft mit iOS 15 auch lokal

- Kindesmissbrauch: Apple scannt iCloud-Fotos auf bekannte Bilder

Traurig, weil immer noch zuviel!

Mich würde aber mal eher interessieren, wieviele unnötige, manuelle Sichtungen durch Applemitarbeiter stattgefunden haben.

Unwichtig. Spekulationen bringen einem nicht weiter.

Spekulationen helfen nicht weiter, stimmt.

Allerdings will hier auch niemand spekulieren.

Ich habe nichts von spekulieren gesagt.

Was da gebaut wird sind defakto Uploadfilder und damit ist Ende-zu-Ende-Verschlüsselung aufgehoben, selbst wenn sie nicht gebrochen wird. Wenn die beiden Kommunikationsendpunkte (iPhones) nicht mehr vertrauenswürdig sind ist es keine echte e2e mehr.

Ja

Der Filter wurde ja auch letztes Jahr beschlossen. Und ist seit 1.08 auch auf YT im Einsatz.

Genau

Ich frag mich ob die diesen Schwachsinn auch unter MacOS einführen werden.

Nein, ganz im Gegenteil: Dadurch wird eine Ende-zu-Ende- Verschlüsselung möglich, ohne gegen lokale Gesetzte zu verstoßen. Das durchsuchen nach KiPo ist entweder in vielen Staaten Pflicht, oder geplant (EU).

Somit ist das nur möglich, dass Fotos in der Cloud vom Anbieter entschlüsselt und durchsucht werden können. Apple will das aber auf dem Gerät machen und dann die Fotos ohne Generalschlüssel speichern. Was ist dir lieber? Fotos in der Cloud, auf die jeder Ermittler Zugriff hat, oder einen Scanner vor dem Upload?

Es wird diese Verschlüsselung nie geben!!! Begreif das doch! Du schreibst das hier jetzt zum 100. mal! Es stimmt nicht, Das ist gelogen! Apple hat das nie gesagt und auch fragen dazu immer dementiert!

Danke. + 1.000

@stimmtnicht, natürlich

Das sollte „no content“ heißen.

Der Satz beißt sich wieder: „um lokale Fotos … zu durchsuchen.“

Das ist falsch. Richtig wäre: „um Fotos lokal zu durchsuchen.“

Kleiner aber feiner Unterschied.

Ich melde mich mit Tomaten auf den Augen: Wo ist hier im konkreten Fall der Unterschied? Apple hat den lokalen Scan lokaler Fotos angekündigt, noch bevor diese den Upload in Richtung iCloud antreten.

Hier aus Apples Technical Summary:

„Before an image is stored in iCloud Photos, an on-device matching process is performed for that image against the database of known CSAM hashes. „

„Lokale Fotos zu durchsuchen“ lässt die Möglichkeit offen, dass diese Fotos erst hochgeladen werden, un durchsucht zu werden. Umgekehrt ist’s halt präziser.

Wie du es schreibst hört es sich an, als wenn lokale Fotos durchsucht werden. Das ist nicht Fall.

Es werden lokal Fotos durchsucht, bevor sie in die iCloud geladen werden, bei aktivierter iCloud Mediathek. Das ist ein großer Unterschied.

@Tim: Wo liegen die Fotos denn, die lokal durchsucht werden? Das sind doch lokale Fotos.

Es werden, nach jetzigem Stand, nicht alle lokalen Fotos gescannt. Aber trotzdem ist die Aussage richtig.

Da bin ich auch bei @Peter. Das hier zu sugarcoaten und immer wieder auf die vorgebliche iCloud-Grenze zu verweisen, halte ich eher für verwirrend. Wer weiß denn schon wann ein Bild in die iCloud geht.

Dies ist ja nicht nur der Fall wenn die iCloud-Fotomediathek aktiv ist, sondern auch wenn ein Foto per iMessage verschickt wird und Messages in der Cloud aktiviert ist. Oder ein Foto in einem Pages Dokument landet, und Pages neue Dokumente standardmäßig in iCloud speichert. Oder Wenn die iCloud-Fotomediathek aus, aber der iCloud-Fotostream an ist. Es gibt so viele Berührungspunkte mit iCloud, dass man gut damit beraten ist anzunehmen, dass alle Bilder mit dieser in Kontakt kommen können.

Und nochmal: Die Fotos werden lokal durchsucht bzw. abgeglichen, *vor* einem iCloud-Upload.

Da muss ich Peter auch recht geben, so hatte ich das noch nicht gesehen. Die Bilder sind ja deshalb trotzdem lokal.

Okay, überzeugt.

Hätte mir nur gewünscht, dass der Hinweis „vor dem iCloud Upload“ direkt kommt und nicht erst im nächsten Absatz.

Sehe ich auch so. Diese Argumentation ist nur Haarspalterei um zu vertuschen, dass man unsere Endgeräte scannen möchte.

Apple schreibt selbst:

Before an image is stored in iCloud Photos, an on-device matching process is performed for that image against the known CSAM hashes.

Das ist erstmal ziemlich eindeutig welche Fotos gescannt werden. Alles andere ist deine Vermutung oder Befürchtung.

Die korrekte Terminologie wäre dann: Die lokal auf dem Gerät gehaltenen Fotos werden lokal ohne Netzwerkkontakt vom iOS durchsucht, gehashed und lokal verglichen. Wird ein Match gefunden, DANN wird das Bild hochgeladen (?) und gemeldet.

Wann wird eigentlich die Datenbank mit den „positiv“ Werten geladen oder ist die fix im iOS verankert? Sonst kommen findige Leute und sperren dieses „Update“ z.B. im DNS und ohne Liste kann nichts gefunden werden :-) …

Aber wenn sie statisch im iOS hinterlegt ist, dann wird sie auch nicht so schnell „aktualisiert“. Fragen …. :-)

@nicolas: Es ist sehr wohl ein großer Unterschied: Wenn Du schreibst, dass lokale Bilder gescannt werden, impliziert das, dass die auch gescannt werden, wenn die iCloud-Fotos nicht genutzt wird. Das stimmt aber nicht.

Die Funktion wird erst aktiviert, wenn man die iCloud Fotos aktiviert. Und das kann jeder sehr wohl leicht kontrollieren, ob da der grüne Button aktiviert ist.

https://www.macrumors.com/2021/08/05/apple-csam-detection-disabled-icloud-photos/

Wer die Fotocloud aber bisher genutzt hat, dessen Fotos wurden auch vorher danach durchsucht, egal bei welchem Anbieter, bei Google sogar die Mails, bei Facebook der Messenger. Hat anscheinend niemanden interessiert.

Auch das Argument, Apple könnte die Funktion heimlich auch für diejenigen aktivieren, die keine iCloud nutzen ist unsinnig, denn die Fotos während gerichtlich nicht verwertbar, weil illegal beschafft.

Der Vorteil wird hier auch nie erwähnt: Die Fotos sollen nach dem Update -wenn man keine Treffer hatte – endlich verschlüsselt in der Cloud lagern, ohne dass Apple noch einen Schlüssel hat. Damit wären die Fotos auch für Ermittlungsbehörden sicher.

@tommiw: was denn jetzt? Beißt es sich oder triggert es dich nur?

Bitte informiere bevor du hier für Verwirrung sorgst.

Die Bilder werden lokal durchsucht PUNKT!

Wie soll denn sonst, verhindert werden, dass ein verdächtiges Bild in die Cloud gerät?!

Aber genau das hat er doch geschrieben. Die Fotos werden lokal durchsucht. Er sagt doch ausdrücklich das der immer wiederkehrende Verweis auf die „Cloud-Grenze“ hier haltlos ist, weil so ziemlich alles immer in Kontakt mit Apples Servern steht.

Und da hat er auch recht.

Vertrauen beruht immer auf Gegenseitigkeit.

Wenn Apple mir nicht mehr vertraut, weshalb soll man dann Apple vertrauen?

So ist es

Hmmmm. Wenn Apple allen Usern vertrauen können sollte, würde kein Apple-User ein Kinderschänder sein.

Siehste selber…?!

Bei den 265 gemeldet Fotos, handelt es sich da um 265 Einzelpersonen die 1 Foto hatten oder um 1 der 265 Fotos hatte. Beides zwar zuviel aber die restlichen Millionen iPhone User hatten diese Fotos nicht und somit wird wegen einer widerlichen kleinen Randgruppe wir alle unter Verdacht gestellt…

Es geht nicht nur um Vertrauen (was ich nach Apples Verhalten in China nicht mehr habe), sondern auch um Verhältnismäßigkeit. Die ist nicht gegeben. Milliarden Fotos durchsuchen um ein paar hundert positive Treffer zu landen? Sollen sie das Geld, die die Überprüfung kostet (IT, Strom, MA) lieber an Kinderschutzorganisationen spenden…

Apple durchsucht diese Milliarden Bilder nicht, richtig? Ihre „Fingerabdrucke“ werden mit „Fingerabdrucken“ in Datenbanken verglichen. Wenn die Wahrscheinlichkeit hoch genug ist, daß sie identisch sind, dann wird überprüft. Oder?

Das Vertrauen nur gegenseitig… tut, klingt nett ist aber falsch. Wie kommst Du darauf? Und noch wichtiger: Wie kommst Du darauf, dass das zutreffend ist?

AirBnB? Echt jetzt?

Wie geht das denn?

Mich wundert eher die „kleine“ zahl bei 4Chan

Wer weis was bei Airbnb noch so alles angeboten wird. Hab mich letztens auch nach einem Apartment umgeschaut. Beim dritten Bild stellte ich fest: im Schlafzimmer liegt eine Dame im knappen Bikini auf dem Bett … Mmh? Falsches Bild evtl? Oder die Vermieterin ?

Die kommenden 5-8 Bilder war die Dame immer wieder zu sehen in verschiedenen Zimmern, im Bad, im Flur etc. Immer im Bikini …

naja hab das nicht gebucht. Kann mir vorstellen da wird das ein oder andere auch mit angeboten. Schlimm

Eine Frau im Bikini, schlimm!

Du hast es nicht verstanden, es ging wohl darum was dahinter steckt. Und mal nebenbei : ich suche ein Apartment und keine Frau!!! Da hat ne Frau auf den Bildern und vor allem in sexy Posen mal gar nichts zu suchen.

Oder kaufst du ein Auto online und es ist ne Frau aufm Rücksitz dabei?

„zeigt sich vom webweiten Aufschrei ansonsten aber weitgehend unbeeindruckt.“ … das geht NUR über rückläufige Umsatzzahlen … befürchte ich … oder die USER verweigern massenhaft iOS15 … aber hier sieht man jetzt leider die Abhängigkeit von einem Tech-Giganten … und mangels Alternativen stellt sich für mich wirklich die Frage … „was nun?“

Apple hat doch keine andere Wahl. Das ist doch ein EU- Beschluss und betrifft alle Anbieter.

Nochmal: Apple hat hier die Wahl! Der Beschluss der EU legt den Grundstein für Online Untersuchungen was schon seit Jahren Gang und Gäbe ist. Lokal auf dem Device ist nicht verpflichtend!

als ob dieses „Feature“ nicht auch für die älteren iOS Versionen per Sicherheitsupdate nachgeschoben wird.

Wenn man sowas schlau macht ist es bei allen schon da aber noch nicht aktiv

Es ist echt nicht böse gemeint, aber ich finde die Medien (damit auch das Team hier) könnten bei dem wichtigen Thema etwas besser recherchieren/arbeiten. Das ist mittlerweile der bestimmt fünfte Artikel über das Thema & jedes Mal lauten die Details leicht anders.

Bei so einem sensiblen Thema, sollte echt haargenau auf die Funktionsweise eingegangen werden und diese erläutert. Ich bin in dem Bereich auch kein Experte, aber ich habe jetzt schon mehrfach auf anderen Seiten gelesen, dass der Abgleich nur stattfindet, wenn man die iCloud Fotomediathek nutzt. Wenn man diese nutzt, dann werden die Bilder wohl lokal auch schon vor dem Upload abgeglichen. Wenn man diese generell nicht nutzt, dann wird wohl auch nichts abgeglichen. Das ist schon mal ein Beispiel, für einen extrem wichtigen Punkt. Wenn das aber alles auf praktisch zwei Headlines verkürzt wird, entstehen falsche Eindrücke und dann geht das stille Post Spiel weiter und kurz darauf titelt die BILD: Cook schaut sich eure Bilder ohne Zustimmung an.

>jedes Mal lauten die Details leicht anders.

Sei so nett und weise uns darauf hin, falls Dir hier eine Unstimmigkeit auffallen sollen: ifun.de@gmail.com

Wir haben den Anspruch richtig und konsistent zu berichten. Bei unseren bisherigen Einträgen zum Thema sollte es keine „leicht anderen Details“ geben.

Das schlimme ist ja die Möglichkeit alles zu scannen. Eine allen Usern unbekannte Datensammlung von hash werten bestimmt, was gemeldet wird. Lass Pegasus mal das Ziel dieser Meldung ändern und Dir lokal ein paar hashes mehr hochladen, dann hast Du die Überwachung perfektioniert.

Du wirst entweder von Apple bezahlt, oder bist Angehöriger der Apple-Sekte. Anders kann Deine blauäugige Argumentation nicht zustande kommen. Dritte Alternative: Du hältst uns alle für blöd.

Erklär einfach warum eine private Firma weltweit die Aufgabe übernehmen will die überall staatlichen Strafverfolgungsbehörden obliegt.

Erklär bitte, was Apple davon abhalten wird als nächste gute Tat alle Mails und iMessages im Hinblick auf Drogenvergehen zu scannen.

Erklär bitte was Apple davon abhalten soll künftig Bitten von Regierungen um Scan bestimmter als schädlich definierter Inhalte abzulehnen, nachdem Apple allen jetzt vormacht wie super das funktioniert?

Wie kann ein Topmanagement so dämlich sein, sich den mühsam aufgebauten guten Ruf in Punkto Datenschutz mit einem Federstrich selbst kaputt zu machen !

Hä? Ist der Kommentar an jemand anderen adressiert? Ich hab das doch gar nicht gut geredet oder Apple in einem Satz verteidigt? Mir ging es darum, dass scheinbar nicht alle Bilder gescannt werden bzw. der Hashwert verglichen wird & das man mit iOS 15 keine Möglichkeit mehr haben soll das zu umgehen. Soweit ich das aber richtig verstanden habe, wird nichts verglichen, wenn man die iCloud Mediathek ausstellt. Das ist für mich ein kleiner aber sehr relevanter Unterschied.

Fernab davon, finde ich das neue „Feature“ auch überhaupt nicht gut & finde die jetzige Lösung (nur wenn man was in die Cloud lädt) besser.

Echt jetzt? Das Thema wann ein Gerät lokal gescannt wird wurde in jedem der Artikel besprochen.

Was ist denn wenn der Schalter für den iCloud Foto Sync mit iOS 15.1 auf defekt gestellt wird? Dann wird dein device lokal gescannt.

Was müh ich mich hier eigentlich ab:

APPLE BAUT EIN SCHEUNENTOR IN DEIN IPHONE! Heute sind es CSAM Fotos. Irgendwann politische Memes oder sonst was.

Merkt ihr Jünger es denn nicht?

Ich habe weder die Maßnahme von Apple verteidigt noch den Hauch der Interpretationsmöglichkeit darüber gelassen, ob ich das überhaupt gut oder schlecht finde. In meinem Kommentar ging es darum, dass so kleine technische Unterschiede viel ausmachen. Und wie Apple mir ab iOS 15.1 den Schalter ausmachen will, wenn ich dann meinen iCloud Speicher bei denen kündige, sollen die mir mal zeigen.

Auch für dich nochmal, weil einige sich vor dem zu Ende lesen scheinbar schon auf die Tische stellen:

Ich bin gegen das lokale scannen der Bilder. Ob von Apple, Cook persönlich oder sonst einem Privatunternehmen.

Apple vertrauen ?

Glaubt hier noch jemand an den Weihnachtsmann?

Und wieder einmal zeigt sich, dass Apples Kundendatenschutz Marketing blabla ungefähr so viel wert ist, wie Apples Umweltschutz Marketing blabla.

Nur 265 Fotos gemeldet und dafür

Ein Topmanagement das sowas zulässt gehört gefeuert!!

Für mich steht fest, dass ich für ein iNarc statt iPhone kein Geld mehr ausgeben und bei Einführung des Scans der Endgeräte künftig statt Apple-Geräte die gleich guten aber deutlich günstigeren Geräte der anderen nicht-Datenschutz-interessierten Hersteller kaufen werde.

Und welche Hersteller sollen das sein?

Er mein bestimmt Huawai ;)

interessiert mich auch, welche Hesteller denn genau?

Ein Experte, der meint, etwas zu Apples Vorgehen beitragen zu können, und dann in den Kommentaren (unter Anderem) zu sowas Grundlegendem wie Apples Zugriff zu iCloud-Inhalten korrigiert werden muß…

Außerdem – seit wann bedingt die „Eins-in-1-Billion“-Chance das Vorhandensein von einer Billion Bildern?

Naja du brauchst schon mindestens einen Fehlalarm, es gibt ja keinen halben oder weiter unterteilten. Kannst das ja schlecht hochrechnen & sagen: bei 100 Milliarden Bildern gab es 0,1 Fehlalarme.

Meine Güte

Ab August glaube ich muss jeder in Deutschland seinen Fingerabdruck wenn er ein neuen Perso beantragt

abgeben und demnächst wird wahrscheinlich deine DNA auch noch irgentwo draufgespeichert .

was sind da schon ein paar

Bilder.

Also nicht soviel aufregen ist nicht gut fürs Herz und ändern werden wir eh nie mehr.

Übrigens die meisten haben ja Facebook und Instagramm u.s.w

eh schon die erlaubnis gegeben zugriff auf die Pfotos zu haben

und die senden eh an alle Welt

Krawetz scheint ja von Statistik und Wahrscheinlichkeitsrechnung keine Ahnung zu habe. Man braucht keine Billionen Testfotos um diese Fehlerquote zu berechnen. Aber so ist das eben in der weltweiten aufgeregten Webwelt. Die üblichen Verdächtigen verdrehen und missverstehen gerne wenn sich die Gelegenheit bietet Apple ans Bein zu p.

Tatsächlich will Apple nur den Zeitpunkt und Ort des Scans verschieben. Müssen sie ja auch wenn sie mit der End zu Endverschlüsselung der iCloud weiter kommen wollen. Und damit wäre das Rätsel um die Motivation eigentlich schon gelöst.

Was bringt mir E2E Verschlüsselung, wenn vorher alles gescannt wird?

Das ist wie Briefgeheimnis, bei dem erst sämtliche Briefe gelesen und dann ordentlich zugeklebt werden, lächerlich.

Wenn ich nicht möchte, dass Microsoft oder Cloud Provider XYZ meine Fotos scannt, dann benutze ich deren Service nicht, fertig.

Bei Apple bin ich mir nicht so sicher, dass ein Staat nicht Apple auffordert, die von Apple installierte Software für staatliche Schnüffelei zu verwenden.

Das ist der fundamentale Unterschied. Apple wird sämtliche Geräte mit Schnüffelsoftware ausstatten, das ist doch etwas ganz anderes als irgendwelche Cloud Provider, die ich nutzen kann oder auch nicht.

Jedermann kann Cloud Speicher anbieten und wen interessiert es schon was die mit den Daten anstellen, aber niemand kann so einfach auf sämtlichen iPhones Schnüffelsw installieren.

Mir ist schleierhaft, warum Apple das nicht auch so sieht.

Und es spielt keine Rolle, dass ja nur bei Nutzung von iCloud gescannt wird blabla.

So naiv kann doch wohl niemand sein. Sobald Apple das installiert hat klopft China etc an und bittet höflich um eine kleine Änderung, damit es „gesetzeskonform“ ist.

1984

Bist ja nicht gezwungen ein iPhone zu nutzen, kannst ja z.B. ein Huawei nehmen :}

In dem Originaldokument steht „Reports“. Vielleicht stammen die 265 Fotos alle von 1 User. Dann ist das natürlich zu vernachlässigen.

„Reports“ ist ja auch nicht gleich verurteilte Straftäter.

Man fragt sich was der ganze Aufwand soll.

Die Frage stellt sich mir warum hat Apple die Scanfunktion nicht auf der WWDC vorgestellt und vernünftig erklärt ? Warum so hastig am Donnerstag veröffentlicht, mit wenigen bis gar keinen Info´s , das mußte doch zu dem Kommunikationsgau führen mit den Protesten im Netz, waren sie so naiv und haben sie geglaubt das die Applebubble das bejubelt bzw, einfach schluckt – Oder steckt da vielleicht was hinter wo Apple einfach der Politik zuvor kommen wollte ….. um nicht an den Pranger gestellt oder wieder vor dem Kongress zitiert zu werden.

Nicht falsch verstehen ich bin gegen den Scan der Bilder auf dem Gerät und halte das für eine ureigene Aufgabe der Strafverfolgungsbehörden in Zusammenarbeit mit der Justiz. Die Funktion die es im Familienacount gibt wo Minderjährige gewarnt werden find ich gut, aber nur weil ich diese Funktion selber aktivieren bzw. deaktivieren kann

Weil man in den USA – und nur dort wird die Funktion aktiviert- die Leute das ganz anders sehen. Da wird Apple auf dem über 90% Zustimmung treffen.

So sieht es wohl aus. Dort ist es sicherlich mehrheitlich ein positives Verkaufsargument. Kann aber gut sein das sie es später hier und auch anderswo auch einführen. Später ziehen vielleicht andere Anbieter nach, so wie bei Fingerabdruck Sensor oder beim Wegfall des Klinkenstecker. Bei denen wird es dann als ganz tolle Sache gefeiert werden.

In USA wird es zuerst aktiviert aber auch in anderen Ländern nach Prüfung der Rechtslage ausgerollt und das die Ankündigung Weltweit für

Aufregung sorgt müßte Apple bewußt gewesen , insbesondere in der EU – Ich kann mir nicht vorstellen das sie diesen Gau erwartet haben – da muß noch was anderes hinterstecken – mal schauen was weiter passiert und wie Apple die Wogen glätten will/wird die bisher bereit gestellten Info´s reichen nicht

Das spyPhone 13 wird mit diesen neuen Features sicher der Hit in China, Saudi-Arabien und vielen anderen Wachstumsmärkten.

Das ist in der Tat ein Problem.

Und DAS ist das eigentliche Dilemma hinter der Sache. Nicht die Diskussion über Kinderpornos auf dem Gerät selbst. Das ist nur eine moralische Korrelation über die man hier nicht diskutieren braucht.

Die Frage: Segnet der Zweck die Mittel?

256 Fotos rechtfertigen alles, um 1,5 Mrd iOS devices zu durchsuchen, Verhältnismäßigkeit deluxe, lol. Das wird garantiert juristisch noch kassiert werden.

Ich geh auch davon aus das die Scanfunktion vor Gericht landet – wird ein langer Weg durch die Instanzen

Nicht wenn lang und breit vorher nicht kommuniziert wurde bzw. wenn nach dem Aktualisieren ein Hinweis kommt der zu bestätigen ist. Ist zwar wie bei der AGB aber trotzdem …

ähem … das „nicht“ in „vorher kommuniziert“ bitte streichen :-)

Unglaublich: Wegen 265 gemeldeten Fotos filzt der Konzern demnächst weltweit sämtliche iPhones?

Einen Vorstand der sowas und den damit verbundenen massiven Imageschaden zulässt sollte man feuern!

Es geht um 21 Millionen Mißbrauchsverdächtigungen allein 2020. Wie willst Du das unterbinden?