iOS 10 erweitert iPhone und iPad um 200MB-Gehirn

Apple nutzt die mediale Sommerpause seit Wochen geschickt aus. Neben zwei massiven Firmen-Porträts im Wirtschaftsmagazin Fast Company und einem persönlichen Interview mit Tim Cook, hat das Unternehmen nun auch einen 5000-Wort-Aufsatz über Apples Anstrengungen im Bereich Maschinelles Lernen zur Freigabe autorisiert.

Den Artikel The iBrain is here, des amerikanischen Journalisten und Buchautors Steven Levy, möchten wir euch als klare Leseempfehlung mit in den anbrechenden Donnerstagabend geben und gleichzeitig auf zwei interessante Abschnitte des verweisen, die zumindest ansatzweise erklären, wie Apple auf seinen Mobilgeräten zukünftig plant, künstliche Intelligenz aus Erfahrungen zu generieren.

Ein 200MB-Gehirn in iPhone und iPad

Zum einen wird Cupertino sein Mobil-Betriebssystem iOS 10 mit einem 200MB großen Zwischenspeicher ausstatten, der sich – lokal auf den Geräten – um die Analyse eurer Nutzung kümmern soll.

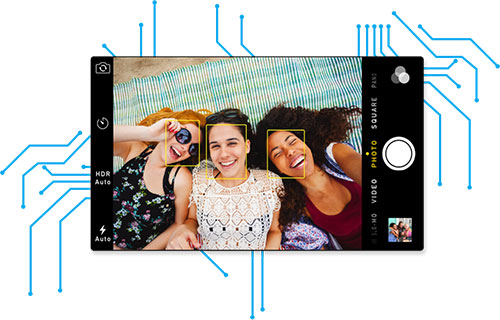

Dieser wird Informationen über eure App-Nutzung, über die Interaktionen mit euren Kontakten, eure Sprach-Eigenarten und euren Geräte-Einsatz sichern und die im Gerät aktiven, neuronalen Netze zudem mit Daten füttern, die bei der Gesichtserkennung der Kamera und der Analyse von Bildern zur Hand gehen sollen.

Machine learning, my briefers say, is now found all over Apple’s products and services. Apple uses deep learning to detect fraud on the Apple store, to extend battery life between charges on all your devices, and to help it identify the most useful feedback from thousands of reports from its beta testers. Machine learning helps Apple choose news stories for you. It determines whether Apple Watch users are exercising or simply perambulating. It recognizes faces and locations in your photos. It figures out whether you would be better off leaving a weak Wi-Fi signal and switching to the cell network.

How big is this brain, the dynamic cache that enables machine learning on the iPhone? Somewhat to my surprise when I asked Apple, it provided the information: about 200 megabytes, depending on how much personal information is stored (it’s always deleting older data).

Ebenfalls interessant ist der bevorstehende Ausbau der Sprachassistentin Siri. Diese soll eure Anfragen, durch den Einsatz der neuronalen Netze und der Methoden zum maschinellen Lernen, nicht nur deutliche effektiver beantworten, sondern auch mit einer hörbar besseren Sprachausgabe ausgestattet sein. Eine Lese-Empfehlung.

With iOS 10, scheduled for full release this fall, Siri’s voice becomes the last of the four components to be transformed by machine learning. Again, a deep neural network has replaced a previously licensed implementation. Essentially, Siri’s remarks come from a database of recordings collected in a voice center; each sentence is a stitched-together patchwork of those chunks. Machine learning, says Gruber, smooths them out and makes Siri sound more like an actual person.

Offtopic: iOS 9.3.5 ist verfügbar

Hier notiert: http://www.iphone-ticker.de/si.....-5-100860/

Ich bin gespannt!

Die Funktionen und Qualität von Siri ärgern mich zunehmend. Selbst nach mehrfacher, deutlichster Aussprache eines Namens in den Kontakten kann Siri damit nichts anfangen. Außerdem ist es blamabel, dass Siri mit dem Befehl „Neuen Kontakt erstellen“ antwortet, dass es das nicht dürfte.

Ganz dramatisch wird es, muss man Englisch und Deutsch mischen. Es kann für Siri wohl nicht sein, dass man als Deutscher auch englische Namen kennt.

Ich werfe Apple geradezu Faulheit zu, was die Weiterentwicklung von Siri angeht.

Die Spracherkennung ist auch sehr schlecht, das kann Google wesentlich besser. Ich frage mich wo da die Verbesserungen von Siri sein sollen. Aber vielleicht wird das ja alles erst mit iOS 10 besser. Apple verbandelt ja gerne seine Dienste mit ihren neusten Systemen.

Namen kannst du beibringen.

Mit iOS 10 ist die Mischung aus englisch und deutsch deutlich besser.

Aber die Tastaturen sind immer noch einsprachig… Völlig bescheuert für jemand wie mich, der deutsch ist und deutsch / englisch permanent abwechselnd benutzen muss…

@gruenix

Die Tastaturen kannst Du doch bei iPS über das Weltkugel Symbol leicht umschalten. Du musst Dir nur mehrere Tastaturen in den Einstellungen einstellen, also für jede Sprache eine.

Nein, mit iOS 10 ist das nicht mehr so.

Du musst nur noch deine Tastatur auf US Englisch einstellen, kannst dann damit trotzdem deutsch schreiben und der erkennt das hervorragend wenn du zwischen den Sprachen wechselst mit der selben Tastatur! :)

auf meinem iPhone 5 funktioniert Siri unter 9.3 richtig gut und unter iOS 10 richtig klasse und rasant schnell.

+1

Also da taucht mit *Datensammelei* kein besonders positiver Begriff in meinem Kopf auf.

Das Wort kommt doch gar nicht vor. Und so ist das nunmal. Ohne dass man dem Gerät ein paar tausend Gesichter zeigt kann es nicht lernen, wie ein Gesicht aussieht. Man kann zwar darüber diskutieren ob man das braucht, aber definitiv nicht darüber ob man das auch ohne große Datenmengen kann. In dem Fall sind wir noch auf der sicheren Seite, da Apple unsere Bilder, zumindest angeblich, nicht zum Training der Netze verwendet.

Naja, nicht ganz richtig. Die Daten verlassen ja eigentlich so wie’s Apple jetzt sagt nicht dein Gerät.

Und die Bilder werden ja Lokal von den neuronalen Netzen durch sucht, also die nutzen schon unsere Bilder, aber um das lokale Netz zu trainieren.

Ganz genau! Ich muss nur noch einmal kurz meinen Senf dazu geben: das Netz ist bei der Auslieferung schon fertig trainiert, lokal wendet es die trainierten Parameter dann nur noch an.

Und ich muss mich selbst auch noch mal korrigieren, weil ich blöd bin: tatsächlich wird unabhängig von dem schon fertigen Netz, das die Gesichter in den Bildern erkennt, selbstverständlich noch ein weiteres Modell trainiert, das lernt welches Gesicht zu welcher Person gehört. Aber ich schätze, dass hierfür kein neuronales Netz mehr notwendig ist, da hier nur noch die Distanz der berechneten Cluster ausgewertet werden muss. Nehme ich mal an, detailliertes Hintergrundwissen habe ich natürlich nicht.

Nur lokal!

Finde ich auch, Datensammelei ist garantiert, tatsächlicher Nutzen ungewiss.

Es wird Zeit, dass man Siri etwas beibringen kann!

Ich stelle mir das Szenario so vor: Auf ein Ergebnis von Siri sage ich „Siri das war falsch“ darauf müsste Siri sagen: „Dann zeige mir bitte wie es richtig geht “ Das müsste Siri in den Lern-Modus versetzen. Ich könnte jetzt ähnlich wie bei VBA (Microsoft Excel) zeigen (Aufnahme) was ich meine.

+1

200MB für ein Gehirn…das wäre nichtmal für ne Ameise ausreichend, aber ist halt PR, da muss man ja was hinzaubern :D

Aber finde es interessant, wie sich diese Art von Technologie entwickelt. Soll ja schon Fortgeschrittene autonome Systeme geben. Siehe den MotoBot von Yamaha, welcher auf der Rennstrecke entwickelt wird. Bald gibt’s MotoBotGP haha :D das wird ein Spaß

Ich nutze Siri nur noch für ein Befehl: Hey Siri, starte Google :-)

Danach klappt es super mit der Spracherkennung durch Google

Das ist der Overkill für jeden kreativ schaffenden Anwender. Es sind gerade die unvorhergesehenen Zufälligkeiten, die zu künstlerischen Ergebnissen werden. Da ist eine verhaltensbasierte KI, die unter Umständen noch korrigiert.. Ich mag den Gedanken gar nicht zu Ende denken. Kann nur hoffen, dass sich der Schwachsinn deaktivieren, bzw. erst gar nicht aktivieren lässt.

Nutzt du Facebook oder youtube? Das sind zwei Beispiele die mir gerade einfallen bei denen genau das passiert: Vorfiltern und dir nur zeigen was am besten passt… Nur bei iOS soll das Lokal umgesetzt werden. Das finde ich super, da nicht irgendjemand aus dem reinen Nutzerverhalten durch gezielte Werbung Milliarden ziehen kann…

Da hat doch das eine nichts mit dem anderen zu tun. Die Aufgaben, die das maschinelle Lernen heutzutage abnehmen kann, beschränken sich ohnehin auf das Finden von Mustern in großen Datenmengen, die der Mensch schon gar nicht mehr überschauen kann. Bis ein Computer auch in der Lage ist, Musik zu schreiben oder Texte zu verfassen wie ein Mensch es tut, vergehen sicher noch Jahrzehnte. Und ich meine damit echte Kreativität. Das was neuronale Netzwerke heutzutage vollbringen beschränkt sich immer noch auf das zufällige Zusammenwürfeln von Mustern, die es davor schon gesehen haben muss.

Do lange Siri nicht deutsch und englisch gleichzeitig versteht, bleibt das alles ein no-go für mich. Und ganz ehrlich ohne serverseitige Auswertung wird AI nicht in Fahrt kommen.

I wechsle ständig zwischen Deutsch und Englisch. Man kann über Einstellungen, …, Tastatur hinzufügen neue Tastaturen hinzufügen und dann die englische Tastatur über die Weltkugel auswählen

Aber die Autokorrektur erkennt immer eine Seite als falsch, möchte sämtliche deutschen oder englischen bzw. spanischen Wörter korrigieren. Also daher fehlt wohl eine zwei bis drei sprachige Verknüpfung. Und eine Lernfunktion. Denn konnte wird bei mir immer in könnte korrigiert. Und bzw. kennt das System zB. auch nicht.

Das kannst du dann manuell in den Tastatureinstellungen eintragen. fügen.

@thestormy

Es echt nicht um das Keyboard. Das versteht unter ios10 sogar mehrsprachige Eingaben, sondern um Siri.